- همه چیز درباره خرید سرورمجازی ایران

- هاست ایمیل چیست و هر آنچه بایستی در مورد ان بدانید

- 101 نکته سریع و کاربردی SEO که بسیار زیاد هستند

- 10 نکته مهم در مورد SEO که باید بدانید

- 3 راه برای پیروزی در SEO در سال 2020 و فراتر از آن

- SFTP چیست؟ و هر آنچه که بایستی در مورد sftp بدانید

- سرور اختصاصی چیست و هر آنچه بایستی در مورد آن بدانید

- بررسی ثبت دامنه و چگونه می توان فهمید که صاحب دامنه کیست

- چگونه متخصص سئو شویم ؟ [10مرحله]

- آیا سرور مجازی میکروتیک رایگان مناسب کسب و کار من است؟

آخرین مطالب

امکانات وب

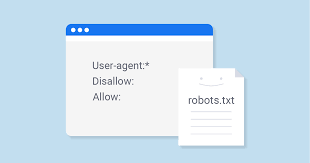

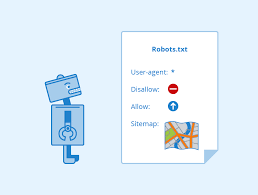

توسط و سوابق ، سوابق robots.txt نشان می دهد که آیا متخصصان خاص مشتری (برنامه نویسی در وب) می توانند بخش هایی از یک سایت را خزیده یا خیر. این دستورالعمل های Slough با "انکار" یا "مجاز" کردن عملکرد برخی از اپراتورهای مشتری (یا همه) مشتری مشخص می شوند.

سئو چیست ؟

پیکربندی اساسی:

متخصص مشتری: [نام کاربری اپراتور]

ممنوع: [رشته URL خزنده نمی شود]

با هم ، این دو خط به عنوان یک سند robots.txt در کل مشاهده می شوند - با این وجود یک ربات ضبط می تواند شامل چندین خط متخصص و موظف مشتری (به عنوان مثال ، امتناع ، مجوز ، تأخیر در شکسته شدن و غیره باشد).

در داخل رکورد robots.txt ، هر ترتیب از دستورالعمل های تخصصی مشتری به صورت یک مجموعه گسسته ، جدا شده توسط یک خط جدا نشان داده می شود:

سفارشات متخصص مشتری که با قطع خط مشخص می شوند.

در یک سند robots.txt با سفارشات متخصص مختلف مشتری ، هر قانون منع یا مجوز فقط مربوط به کاربر (بازدید کنندگان) تعیین شده در آن مجموعه جدا شده از خط خاص است. در صورتی که این سند حاوی یک استاندارد باشد که برای بیش از یک اپراتور مشتری اعمال شود ، یک خزنده فقط روی صریح ترین گردهمایی دستورالعمل ها (و پیگیری سفارشات در آن) تمرکز خواهد کرد.

در اینجا یک مدل وجود دارد:

Robots.txt.png؟ mtime = 20170427090303 # دارایی: 5201: بزرگ

Msnbot ، discobot و Slurp کاملاً صریحاً برداشته می شوند ، بنابراین آن دسته از متخصصین مشتری فقط در بخش های مربوط به سند robots.txt روی سفارشات تمرکز می کنند. سایر متخصصین مشتری سفارشات را در اپراتور مشتری دنبال می کنند: * جمع آوری.

مدل robots.txt:

در اینجا چند نمونه از robots.txt در زندگی واقعی برای یک سایت www.example.com آورده شده است:

URL ضبط Robots.txt: www.example.com/robots.txt

هدایت همه خزنده های وب از همه مواد

متخصص مشتری: *

ممنوع کرده است:/

استفاده از این ساختار زبانی در یک سند robots.txt به تمام خزندگان وب توصیه می کند که هیچ صفحهای را در www.example.com ، از جمله صفحه فرود نگیرند.

دسترسی به همه خزندگان وب به همه مواد مجاز است

اپراتور مشتری: *

انکار:

استفاده از این ساختار زبان در یک سند robots.txt به خزندگان وب توصیه می کند تمام صفحات موجود در www.example.com ، از جمله صفحه فرود را خزش کنند.

هدایت یک خزنده وب خاص از یک سازمان دهنده خاص

اپراتور مشتری: Googlebot

رد کنید: / زیر پوشه مدل /

این ساختار زبان فقط به خزنده گوگل (نام متخصص مشتری Googlebot) می گوید هیچ صفحه ای را که حاوی رشته URL www.example.com/melel subfolder / است ، خزید.

هدایت یک خزنده وب خاص از یک صفحه خاص

اپراتور مشتری: Bingbot

امتناع: / subfolder model / block-page.html

این دستور زبان فقط به خزنده بینگ (نام متخصص مشتری بینگ) می گوید که از لاغر شدن صفحه خاص در www.example.com/model subfolder / block-page خودداری کنید.

robots.txt چگونه کار می کند؟

خزنده وب دو شغل اصلی دارد:

ایجاد وب برای یافتن محتوا.

سفارش آن ماده بنابراین به جستجوگرانی که در جستجوی داده ها هستند ، خدمت می شود.

برای ایجاد خزش در محل ، ایندکس وب پیوندها را دنبال می کند تا با شروع یک صفحه وب سپس به صفحه بعدی شروع شود - در آخر ، تعداد زیادی از اتصالات و سایتها به صورت متقاطع تقسیم می شوند. این رفتار خزنده بعضی اوقات به عنوان "عنکبوت" شناخته می شود.

در پی فرود در یک سایت اما قبل از اسپایدر کردن آن ، خزنده تلاش برای یافتن یک سند robots.txt جستجو می کند. در صورت امكان خاموش كردن یكی ، خزنده ابتدا قبل از ادامه صفحه ، آن سند را جستجو می كند. از آنجا که سند robots.txt حاوی اطلاعاتی در مورد چگونگی شکاف خزنده وب است ، داده های کشف شده در آنجا فعالیت خزنده بیشتر را در این وب سایت خاص آموزش می دهند. در صورتی که سند robots.txt حاوی هیچگونه سفارشاتی باشد که از عملکرد یک سرویس دهنده مشتری امتناع ورزد (یا اگر سایت رکورد robots.txt را نداشته باشد) ، همچنان به داده های دیگر در سایت می کشد.

دیگر robots.txt روشن باید بدانید:

(در مورد جزئیات بیشتر در زیر صحبت شده است)

تا کشف شود ، یک سند robots.txt باید در رجیستری سطح بالا سایت قرار بگیرد.

Robots.txt مورد لمس است: پرونده باید "robots.txt" باشد (نه Robots.txt ، robots.TXT یا چیز دیگری).

برخی از متخصصان مشتری (روبات) ممکن است تصمیم بگیرند که از سند robots.txt شما بی اعتنایی کنند. این خصوصاً با خزنده هایی که بتدریج وحشتناک مانند روبات های مخرب یا اسکرابرهای آدرس ایمیل دارند ، طبیعی است.

سند / robots.txt یک آشکارا در دسترس است: به سادگی تا آنجا که ممکن است از هر منطقه ریشه ای برای دیدن دستورات آن سایت ، اضافه کنید / robots.txt (در صورت این

سایت دارای رکورد robots.txt است!). این بدان معناست که هر کسی می تواند درک کند که صفحات شما چه کاری انجام می دهند یا تمایلی به خزنده بودن ندارند ، بنابراین از آنها برای کف کردن داده های مشتری خصوصی استفاده نکنید.

هر زیر دامنه در فضای ریشه از رکوردهای جداگانه robots.txt استفاده می کند. این حاکی از هر دو blog.example.com و shembull.com باید اسناد robots.txt مخصوص به خود را داشته باشد (در blog.example.com/robots.txt و مثال.com/robots.txt).

معمولاً بهترین روش برای نشان دادن مساحت نقشه های سایت مربوط به این فضا در پایه ربات robots.txt است. در اینجا یک مدل وجود دارد:

نقشه های سایت در robots.txt

ساختار زبان تخصصی robots.txt

ساختار جمله Robots.txt را می توان "زبان" سوابق robots.txt دانست. پنج اصطلاح اساسی وجود دارد که شما به احتمال زیاد در یک ربات رکورد دارید. آنها شامل موارد زیر هستند:

Operator Client: خزنده وب خاصی که به شما دستورالعمل های Slough (معمولاً جستجوگر اینترنت) می دهید. جمع بسیاری از اپراتورهای مشتری را می توان در اینجا یافت.

Forbid: جهت مورد استفاده برای مشاوره به متخصص مشتری برای خلال URL خاص نیست. فقط یک خط "رد:" در هر URL در نظر گرفته شده است.

مجوز (فقط برای Googlebot مناسب است): علیرغم اینکه صفحه اصلی یا زیر پوشه آن ممکن است رد شود ، جهت افشای آن به Googlebot می تواند به یک صفحه یا زیر پوشه برسد.

تأخیر در خزش: یک خزنده شماره چه ثانیه ای باید قبل از جمع آوری و کاهش محتوای صفحه نگه داشته شود. توجه داشته باشید که Googlebot این سفارش را به رسمیت نمی شناسد ، اما نرخ خزش می تواند در کنسول جستجوی Google تنظیم شود.

نقشه سایت: برای خارج کردن منطقه از نقشه های نقشه سایت XML (های) مرتبط با این URL استفاده می شود. توجه داشته باشید که این مسیر فقط توسط Google ، Ask ، Bing و Yahoo تقویت شده است.

هماهنگی مثال

با توجه به URL های اصلی مربع یا اجازه ، اسناد robots.txt می توانند واقعاً با مشکل روبرو شوند ، زیرا اجازه استفاده از هماهنگی های مثال را برای پوشش دادن دامنه انتخاب URL قابل تصور می دهند. Google و Bing هر دو به دو مفصل استاندارد احترام می گذارند که می تواند برای تشخیص صفحات یا زیر پوشه هایی که نیاز به SEO دارد ممنوع باشد. این دو شخصیت شاخص (*) و علامت دلار ($) هستند.

* یک ترامپ است که به هر ترتیب از شخصیت ها صحبت می کند

$ با پایان URL مطابقت دارد

گوگل در اینجا یک نمونه فوق العاده از نمونه قابل تصور را SEO با هماهنگی ساختار جمله و مدل ارائه می دهد.

robots.txt به کجا می رود؟

در هر نقطه که به یک صفحه وب می روند ، ابزارهای جستجو در وب و سایر روبات های خزنده وب (مانند خزنده فیس بوک ، Facebot) می دانند که یک رکورد robots.txt را جستجو کنید. با این وجود ، آنها در یک نقطه صریح آن پرونده را جستجو می کنند: رجیستری اصلی (معمولاً فضای ریشه یا صفحه فرود). به شرطی که یک اپراتور مشتری از www.example.com/robots.txt بازدید کند و یک سند روبات را در آنجا کشف نکند ، انتظار دارد که سایت دارای این سایت نباشد و با کوچک کردن همه موارد در صفحه (و احتمالاً در کل سایت) صرف نظر از اینکه صفحه robots.txt در ، دولت ، مثال.com/file/robots.txt یا www.example.com/landing page / robots.txt وجود داشته باشد ، توسط اپراتورهای مشتری و از این طریق سایت پیدا نمی شود. با آن برخورد خواهد شد که گویی هیچ رکوردی در هیچ تصویری از تخیل ندارد.

به منظور تضمین یافتن سند robots.txt شما ، آن را برای شاخص اصلی یا فضای ریشه خود به یاد داشته باشید.

به چه دلیلی به robots.txt احتیاج دارید؟

اسناد Robots.txt دسترسی خزنده را به مناطق خاص سایت شما کنترل می کند. اگرچه این امر می تواند به احتمال زیاد خطرناک باشد که شما ناخواسته Googlebot را از کل سایت خود ممنوع کنید (!!) ، شرایطی وجود دارد که یک سند robots.txt می تواند مناسب باشد.

برخی موارد استفاده منظم شامل موارد زیر است:

عدم نمایش محتوای کپی در SERPs (توجه داشته باشید که روبات های متا غالباً تصمیم برتر برای این کار هستند)

بخشهای کامل یک سایت را خصوصی نگه دارید (به عنوان مثال سایت سازماندهی گروه طراحی شما)

جلوگیری از نمایش صفحات موارد داخلی در SERP باز

تعیین مساحت نقشه سایت (ها)

جلوگیری از سفارشگرهای وب از سفارش سوابق خاص در سایت شما (تصاویر ، PDF و غیره.)

هنگام تأخیر در هنگام بارگیری خزندگان ، بارها و بارهای مختلفی را روی دوبرابر نشان می دهد که تأخیر در شکاف ایجاد می کند.

در صورت عدم وجود مناطقی در سایت شما که باید برای دسترسی به اپراتور مشتری آنرا کنترل کنید ، ممکن است به هیچ تصویری نیاز به یک سند robots.txt نداشته باشید.

بررسی شانس خاموش بودن یک سند robots.txt

مطمئن نیستید که یک سند robots.txt دارید؟ فقط فضای ریشه خود را تایپ کنید ، در آن مرحله URL / robots.txt را تا حد ممکن اضافه کنید. به عنوان مثال ، ربات ربات های Moz در moz.com/robots.txt قرار دارد.

با فرض اینکه هیچ صفحه .txt نشان داده نشود ، شما اکنون یک صفحه (robot.txt) زنده (زنده) ندارید.

موثرترین روش برای ثبت رکورد robots.txt

در صورتی که کشف کردید که سابقه robots.txt ندارید یا نیاز به تنظیم موارد خود دارید ، ساختن آن یک روش ساده است. این مقاله از Go

سعی کنید از robots.txt استفاده نکنید تا اطلاعات ظریف (مانند داده های مشتری خصوصی) را از نتایج SERP پیش بینی کنید. از آنجا که صفحات مختلف ممکن است مستقیماً به صفحه حاوی داده های شخصی (با این روش با دور زدن سفارشات robots.txt در قسمت اصلی یا صفحه فرود) متصل شوند ، متصل می شوند ، حتی ممکن است در اینجا لیست شود. به شرطی که باید صفحه خود را از موارد پرس و جو بازدارید ، از یک استراتژی جایگزین مانند امنیت عبارت مخفی یا دستور متا noindex استفاده کنید.

برخی از ابزارهای جستجوی وب دارای اپراتورهای مشتری زیادی هستند. به عنوان مثال ، گوگل از Googlebot برای جستجوی طبیعی و Googlebot-Image برای جستجوی تصویر استفاده می کند. اکثر اپراتورهای مشتری از یک جستجوگر اینترنتی مشابه ، اصول مشابهی را حفظ می کنند ، بنابراین هیچ دلیل قانع کننده ای برای تعیین سفارشات برای هر یک از خزنده های مختلف فهرست وب وجود ندارد ، اما با این وجود قادر به انجام این کار به شما امکان می دهد چگونگی بریده شدن محتوای صفحه وب خود را تغییر دهید.

یک جستجوگر اینترنتی ماده robots.txt را ذخیره می کند ، اما به طور معمول هر روز یکبار ماده ذخیره شده را تازه می کند. در صورت تغییر ضبط و نیاز به تجدید سریعتر از آنچه اتفاق می افتد ، می توانید آدرس robots.txt خود را به Google ارائه دهید.

Robots.txt در مقابل روبات های متا در مقابل SEO ربات های x

تعداد زیادی از این ربات ها! تفاوت این سه نوع جهت روبات چیست؟ مهمتر از همه ، robots.txt یک رکورد کتاب واقعی است ، گرچه متا و ربات های ایکس سفارشات متا هستند. گذشته از آنچه که واقعاً هستند ، این سه در ظرفیت های مختلفی خدمت می کنند. Robots.txt سایت یا کاتالوگ رفتار خزش گسترده را هدایت می کند ، در حالی که روبات های متا و x می توانند رفتار نمایه سازی را در سطح صفحه (یا مؤلفه صفحه) انجام دهند.

10 نکته مهم در مورد SEO که باید بدانید

هاست وردپرس...برچسب : نویسنده : کامران تختی wp-hosting بازدید : 187